随着生成式人工智能技术的快速发展,大模型正在深刻改变现代办公方式。从办公文档、会议纪要自动生成,到数据分析可视化、代码辅助编写,大模型凭借其强大的自然语言理解和生成能力,显著提升了各类办公场景的效率。一些机关、单位也开始将大模型深度整合到办公平台中,仅需简单描述诉求,就能快速获得相关材料。然而,这种便利性背后也隐藏着信息泄露和内容失真等风险挑战。

隐患分析

敏感数据存在泄露风险。用户上传的数据可能通过模型输出泄露给其他使用者,使用者与大模型交互的内容及历史对话记录也很容易被攻击者截获。如果违规在未设防的大模型中处理涉密敏感数据,存在被非法获取和泄露的风险。

安全漏洞带来安全隐患。在大模型部署和运维过程中,可能存在安全漏洞,如未启用身份认证、插件权限过大等,会给攻击者提供可乘之机,对大模型文件及数据造成威胁。

恶意使用侵犯他人利益。大模型存在模型滥用及恶意使用等问题,可能会被攻击者用于生成恶意代码、钓鱼邮件或进行社会工程学攻击。

典型案例

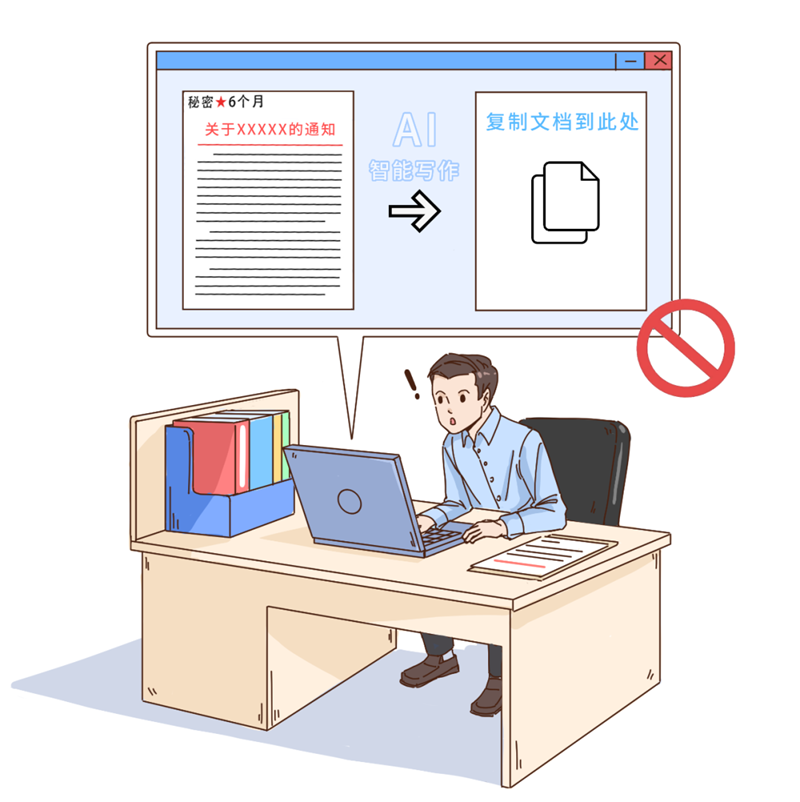

某涉密单位工作人员李某,在起草一份涉密方案时,听同事介绍AI写作很好用,只要写上主题和需求,就可以帮忙写出文稿。李某遂在好奇心驱使下,下载了一款AI写作应用软件,并私自将该涉密方案的部分敏感内容输入AI写作工具,通过AI代写生成网络文件、资料,造成泄密。事件发生后,李某受到严肃处理。

防范措施

增强安全意识。机关、单位工作人员禁止使用部署在互联网上的大模型处理国家秘密;在采用公共大模型辅助办公时,严禁发送敏感词、句进行提问,严禁将内部敏感文件或照片上传至大模型平台。

提高甄别能力。对于大模型生成的内容,要仔细甄别,查看其推理过程是否合理,依据是否充分,避免被大模型“幻觉”误导。

制定保密方案。机关、单位自建包含敏感数据的专用领域大模型,需提前制定安全保密方案,严格按照相关标准要求采取数据加密、权限控制及大模型安全管理等措施。

来源:保密观

初审:邵长青

复审:田野

终审:刘涛